Expertengespräch mit Janna Lipenkova (CEO Anacode/Equintel) und Paul Voges (Entwickler bei EDECY)

Natural Language Processing im Unternehmenskontext

Unter Natural Language Processing (NLP) wird grundsätzlich die Erfassung und maschinelle Verarbeitung von natürlicher Sprache durch künstliche Intelligenz (KI) verstanden. Beide Buzzwords – KI im Allgemeinen und NLP im Besonderen – sind aktuell in aller Munde und standen wohl auch bei den meisten Unternehmen schon einmal auf der Agenda. Wer allerdings anstelle konkreter Vorstellungen bloß hohe Erwartungen mitbrachte, dürfte schnell enttäuscht worden sein. Denn auch wenn im Bereich des Natural Language Processings in den vergangenen Jahren bedeutende Fortschritte erzielt wurden, kann diese Technologie menschliche Tätigkeiten in der Regel zwar unterstützen, nicht aber ersetzen. EDECY hat mit der NLP-Expertin Dr. Janna Lipenkova und seinem verantwortlichen Entwickler Paul Voges über Fortschritte, Herausforderungen und Anwendungsmöglichkeiten der Technologie im Unternehmenskontext gesprochen. Außerdem erklären wir, wie NLP im Forschungsatlas von EDECY eine präzise Themensuche im Dschungel deutscher Forschungsinstitute ermöglicht.

NLP – Herausforderungen und Fortschritte eines interdisziplinären Technologie

Natural Language Processing repräsentiert wie kaum eine anderes Thema die Interdisziplinarität und die damit einhergehende Komplexität moderner Forschung. Das könne, so Janna Lipenkova, zwar zu Spannungen und Herausforderungen führen, mache aber gerade den Reiz aus:

„Man könnte schon sagen, dass wir ein Lager haben, in dem sich primär die Sprach- und Geisteswissenschaftler tummeln, während es im anderen vermehrt die Statistiker und Mathematiker sind. Natürlich prägen diese beiden Richtungen auch die Denkweise und die Arbeitsphilosophie. Häufig ist es gar nicht möglich den [Fach]bereich des anderen so im Detail zu erfassen, wie er es selbst tut. Da prallen schon auch mal verschiedene Weltanschauungen aufeinander.

Gerade aber durch diese Annäherung der Disziplinen – auf der einen Seite die Linguisten, auf der anderen die Mathematiker bzw. Computerwissenschaftler – ergeben sich häufig erstaunliche Erkenntnisse“ (Janna Lipenkova).

Tatsächlich erwies sich diese Zusammenarbeit in den vergangenen Jahren als äußerst produktiv und NLP leistet heute deutlich mehr als die Zuordnung von bestimmten Schlagwörtern und Suchbegriffen. In der klassischen Computerlinguistik lassen sich drei Stufen unterscheiden, die die zunehmende Kontextsensibilität für die Ambiguitäten natürliche Sprache klassifizieren.

- Auf einer ersten Stufe wird der zu analysierende Text in eine Folge von Wörtern (‚Tokens‘) zerlegt, die anschließend eine Lemmatisierung durchlaufen. Ein Lemma ist immer der Ursprungsbegriff, welcher schließlich im Lexikon steht und auf den sich eine jede andere Form zurückführen lässt (z.B. Bücher wird zu Buch). Durch Kompositazerlegung, also die isolierte Betrachtung unterschiedlicher Komponenten desselben Wortes, wird es außerdem möglich, die Wörter Kinderbuch und Buchhandel miteinander in Verbindung zu bringen.

- Diese Verfahren stoßen dort an ihre Grenzen, wo in Texten Personen, Fachbegriffe oder Unternehmensnamen vorkommen, denen an sich keine lexikalische Bedeutung zukommt. Hier können zum einen Verzeichnisse mit Unternehmens-, Produkt- und Personennamen – sogenannte „Gazetteers“ – helfen, auf Basis derer der Algorithmus Eigennamen erkennt. Auf der anderen Seite erlauben bestimmte syntaktische Zusammenhänge häufig bereits Rückschlüsse auf die Bedeutung einer Entität. So sind „liegt in“ oder „fährt nach“ typische Kontexte für Ortsangaben.

- Dieser Ansatz kann zu der syntaktisch-semantischen Analyse kompletter Sätze erweitert werden. Hierbei ziehen Algorithmen aufgrund der bloßen Erkennung von Wortgruppen, Satzstrukturen und Relationen Rückschlüsse auf die Bedeutung ganzer Sätze.

In den letzten 20 Jahren wurde die klassische Computerlinguistik immer stärker durch Maschinelles Lernen ersetzt, welches bei der semantischen Auswertung weniger auf linguistische als auf statistische Verfahren setzt:

„Immer noch haben viele Menschen der Computerlinguistik einen sprachwissenschaftlichen Hintergrund und kommen selbst nicht aus dem Bereich der Informatik. Dadurch stellen sie lexikalische, syntaktische und semantische Aspekte in den Vordergrund. Allerdings sind in den letzten 20 Jahren die verfügbaren Datenmengen sehr stark angewachsen, wodurch die Verwendung des Maschinellen Lernens stark zugenommen hat. Hierbei geht es dann darum, die Datenmengen statistisch zu verarbeiten. Eine große Innovation der vergangenen Jahre sind Wortvektoren. In einer rudimentären Form wurden Wordvektoren bereits in den 80er Jahren verwendet, um auf Basis der statistischen Häufigkeit unterschiedlicher Wörter Aussagen über das Thema eines Textes zu treffen. Hierbei stellt jedes Wort eine eigene Dimension in einem Vektorraum dar. Bei einem Standardvokabular von bis zu 500.000 Wörtern kommt man so schnell auf einen Raum mit über 500.000 Dimensionen. Mit diesem Vektorraum muss man anschließend entsprechend umgehen und ihn für die praktische Anwendung nutzbar machen. Dies geschieht in der Regel über ‚dimensionality reduction‘. Das bedeutet, sich ausschließlich die Cluster von Wörtern zu suchen, die die größte Variabilität entsprechender Achsen haben. Hierdurch wird die Anzahl der Dimension auf 100 bis 1.000 reduziert“ (Janna Lipenkova).

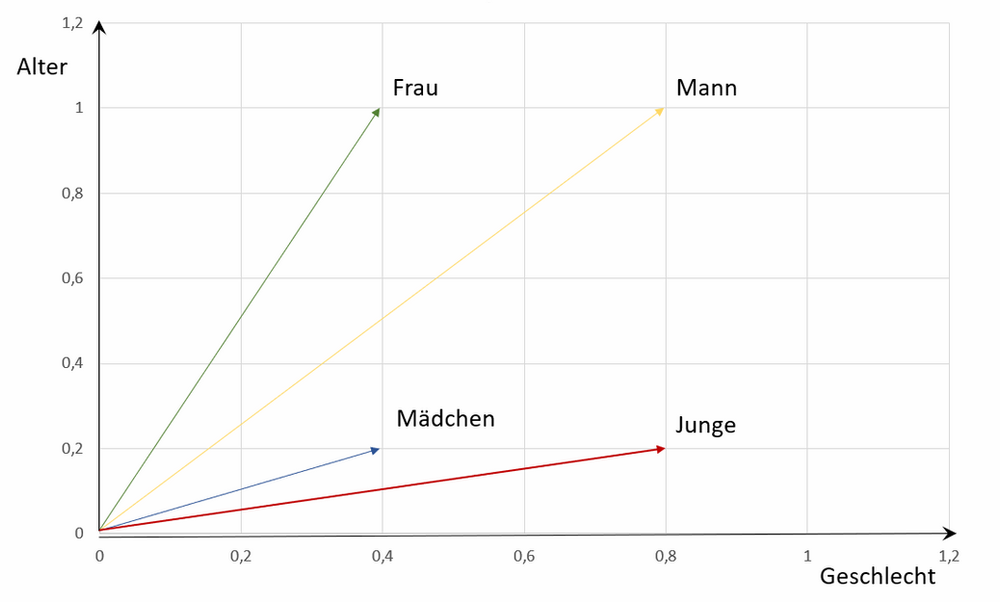

Jede dieser Dimensionen stellt nun eine bestimmte Information dar (z. B. Wohnort oder Geschlecht). Wenn wir als Beispiel die beiden Wörter „Bremen“ und „Hamburg“ in einem Vektorraum verorten, liegen sie wahrscheinlich näher beieinander als das Wort „Rein“, da dieses keine Stadt beschreibt. Ähnlich verhält es sich mit den drei Wörtern „Frau“, „Mädchen“ und „Junge“. In der Dimension des Geschlechts liegen Frau und Mädchen auf einer Dimension, während Mädchen und Junge in Bezug auf ihr Alter einander zugeordnet werden können. Werden diese Beispiele nun durch Maschinelles Lernen auf über 100 Dimensionen ausgeweitet, ergibt sich ein komplexer Vektorraum, in dem die Bedeutung eines Wortes durch eine Vielzahl von Dimensionen definiert wird.

NLP im Forschungsatlas von EDECY

Bei der Arbeit an einem deutschlandweiten Forschungsatlas kam auch bei EDECY schnell das Thema NLP auf den Tisch. Ziel sollte es nicht nur sein, bereits vorstrukturierte Daten aus dem Web auf unserer Website darzustellen, sondern zahlreiche unstrukturierte Projektbeschreibungen und Infotexte so semantisch auszulesen, dass eine präzise Klassifizierung der beteiligten Forschungspartner hinsichtlich Ihrer Forschungsschwerpunkte möglich wird:

„Eines der großen Ziele der EDECY Plattform sollte es sein, dass Nutzer möglichst zielgerichtet nach potenziellen Forschungspartnern auf der Plattform suchen können. In einem ersten Schritt haben wir dafür die Daten von über 18.000 Forschungsinstituten in Deutschland und auch einigen aus dem Ausland gecrawlt und in einer hoch-performanten Datenbank abgelegt. Unsere Nutzer sollten über eine Schnittstelle (API) diese Datenbank ansprechen und anhand besonders festgelegter Suchkriterien durchsuchen können. Hierzu zählen Standort und die Spezialisierung des Forschungspartners oder auch individuell gewählte Suchbegriffe. Das Problem, auf welches wir dabei stießen, war, dass die wirklich detailreichen und relevanten Informationen für die Nutzer häufig nur in langen Fließ- und Beschreibungstexten enthalten waren und von Suchalgorithmen nicht erfasst wurden. Hierbei wurde das Thema Natural Language Processing für uns schnell relevant und wir holten uns Unterstützung durch Janna“ (Paul Voges).

Bei der Erarbeitung des EDECY Algorithmus stellte sich schnell heraus, dass die wissenschaftliche Sprache, welche sich von Disziplin zu Disziplin unterscheidet, eine der zentralen Herausforderungen sein würde.

„Bei dem Auftrag ging es darum, eine end-to-end-pipeline aufzubauen. Das ist praktisch ein System, welches die Daten sowohl einsammelt als auch analysiert und sie schließlich über eine API für einen sehr zielgerichteten Suchalgorithmus zur Verfügung zu stellt. (…) Wir haben nach dem Sammeln der Daten dann einige Algorithmen ausprobiert und uns für einen entschieden, der in Bezug auf die Qualität der Suchergebnisse und die generelle Performance überzeugte. (…) Bei der Auslese dieser doch großen Datenmenge gab es dann natürlich einige Challenges. Die größte Herausforderung lag darin, mit wissenschaftlicher Fachsprache umzugehen. So sind zum Beispiel viele Fachbegriffe aus mehreren Wörtern zusammengesetzt. Ein Begriff, wie Neuronales Netzwerk muss von dem Algorithmus erst einmal als eine semantische Einheit erkannt werden, um dem Suchalgorithmus zugänglich gemacht werden zu können“ (Janna Lipenkova).

Die Stärke des EDECY Forschungsatlas besteht nun darin, dass er in der Lage ist, diese Probleme durch Entitäts-Erkennung und Kompositazerlegung zu umgehen und relevante Begriffe auch dann zu erkennen, wenn sie nur in unstrukturierten Fließtexten wie Forschungspublikationen und Projektbeschreibungen enthalten sind, wo sie zusätzlich häufig syntaktische Verformungen aufweisen. Um mit den schnellen Suchergebnissen bei Google und anderen großen Plattform mitzuhalten, wurde hierfür eine Elasticsearch-Datenbank angelegt, welche darauf ausgerichtet ist, Suchen mit großen Datenmengen durchzuführen und dabei trotzdem schnelle Ergebnisse zu liefern – für den Nutzer geschieht der gesamte Vorgang des Durchsuchens der Datenbank in Millisekunden.

Anwendungsszenarien und Praxistipps für Unternehmen

Neben dem Use-Case von EDECY kommt NLP auch in vielen weiteren Anwendungsfeldern bereits zum Einsatz und kann dort Zeit und Kosten einsparen. Häufig spielt NLP auch eine verdeckte Rolle und ist unter anderem beim Crawlen von Web-Inhalten von Bedeutung.

„Zum einen muss man sich sehr daran anpassen, wie stark NLP bereits in anderen Kontexten genutzt wird. Das fängt im Marketing und Social Media Bereich an. Hier muss man sich an die Algorithmen der großen Social Media Plattform anpassen und schauen, dass die eigenen Inhalte auf die Art und Weise, wie diese Plattformen ihre Informationen auslesen, zugeschnitten sind. Außerdem ist der Kundensupport ein riesiges Thema, hier spielen Chatbots eine immer größere Rolle. Die Idee hierbei ist es, häufige Service-Anfragen und Problemmeldungen automatisiert von künstlichen Intelligenzen beantworten zu lassen“ (Paul Voges).

Auch bei Marketing Analysen kommen immer häufiger NLP-Algorithmen zum Einsatz. Sie erfassen hierbei nicht mehr nur, worüber potenzielle Zielgruppen aktuell sprechen – zum Beispiel welche Produkte gerade im Trend sind – sondern ermöglichen immer häufiger auch detaillierte Sentiment-Analysen. Diese zeigen in ihren Ergebnissen nicht mehr nur an, worüber gesprochen wird, sondern auch wie über ein Thema gesprochen wird. In diesem Zusammenhang können dann Marktforschungen darüber angestellt werden, welche konkreten Eigenschaften eines Produktes gut ankommen und an welchen Stellen noch konkreter Verbesserungsbedarf besteht. Ersetzen aber können auch diese Algorithmen den Menschen in der Regel noch nicht. Janna spricht daher nur in Bezug auf die Augmented-Intelligence (Erweiterte Intelligenz) von einem „Reality-Check“, den diese bestanden hat.

„Im Grunde genommen ist Augmented Intelligence so etwas wie ein Kompromiss, den man macht, nachdem man festgestellt hat, dass Artificial Intelligence bei vielen Aufgaben und Prozessen nun einmal nicht fehlerfrei funktioniert. Sowohl beim Natural Language Processing als auch im klassischen Machine Learning ist es sehr schwer bis unmöglich Genauigkeiten von 100 % zu erreichen, es schleichen sich immer Fehler ein. Bei Augmented Intelligence geht es eben darum, dass Menschen ihre Intelligenz und ihr Hintergrundwissen einsetzen, um solche Fehler zu entdecken.

„Die Illusion, dass komplexe Prozesse schon jetzt vollständig automatisiert werden, wird relativiert. Stattdessen wird der Mensch bei seinen Aufgaben durch KI unterstützt. So kann er nicht nur effizienter arbeiten, sondern sich auch auf die kreativen und menschlichen Aspekte seiner Arbeit konzentrieren. Dies ist ein Ansatz, der sowohl ethisch als auch emotional für die meisten Menschen überaus ansprechend ist.“ (Janna Lipenkova).

Im Falle der Chatbots im Service-Bereich können Unternehmensprozesse beispielsweise verschlankt werden, wodurch Mitarbeitern mehr Zeit für außergewöhnliche Anfragen und Kundenwünsche bleibt. Darüber hinaus kann das Kunden-Feedback durch Service-Formulare und Social-Media Informationen auch so ausgelesen werden, dass es bei zukünftigen Unternehmensentscheidungen einen bedeutenden Informationsvorteil darstellt. Neben diesem Lernprozess, den Wirtschaft und Wissenschaft in den vergangenen Jahren gleichermaßen durchliefen, mussten viele Unternehmen die Erfahrung machen, dass NLP nicht umstandslos einem bestehenden Geschäftsmodell übergestülpt werden kann. Paul fasst die Erfahrungen von EDECY wie folgt zusammen:

„Was mir bei der Zusammenarbeit auf jeden Fall sehr schnell klar wurde, ist, dass man sich – bevor man das Thema NLP überhaupt anpackt – darüber klar sein sollte, wo man gerade eigentlich steht. Im ersten Schritt stellt sich dann die Frage: Brauchen wir künstliche Intelligenz? Brauchen wir NLP? Und vor allen Dingen: welcher Business-Case, welcher Use-Case liegt vor? Anfänglich gilt es also, überhaupt erstmal zu erkennen, an welchen Stellen unseres Produkts wir durch solche Technologien einen Mehrwert schaffen können und wo das nötige Kosten-Nutzen-Verhältnis vielleicht gar nicht gegeben ist. Und dann geht es natürlich auch um das Technische: Wie steht es um unsere aktuelle Software-Architektur? Wie können wir da NLP und KI sinnvoll integrieren? Besonders als Unternehmen, das noch gar nicht mit solchen Themen gearbeitet hat, ist es nicht damit getan einfach auf die aktuelle Software Machine-Learning ‚draufzuklatschen‘.

Im nächsten Schritt geht es dann darum, das erarbeitete Konzept in seine Software zu implementieren. Dabei muss man auch schauen, welches Know-How aktuell bereits in der Firma vorhanden ist und was besser durch Outsourcing bewerkstelligt werden kann. Fachkräfte sind auf dem Arbeitsmarkt gerade sehr rar und begehrt, wodurch es nicht immer möglich ist, eine eigene Entwicklung aufzusetzen.

Daher kann es in vielen Fällen ratsam sein, sich an einen Kooperationspartner zu wenden und mit ihm gemeinsam eine Lösung zu erarbeiten – genau diese Fälle sind es, an denen auch unser EDECY Prinzip deutlich wird“ (Paul Voges).

Mit einer ähnlichen Idee gründete Janna mit zwei Partnern des Wirtschaftsbereiches das Unternehmen Anacode, welches auf die Unterstützung von Unternehmen bei den Themen Deep Learning und Natural Language Processing spezialisiert ist. Da Janna selbst aus der Wissenschaft kommt, kennt sie das Problem des Transfers von der Wissenschaft in die Wirtschaft und sieht auch in den Bereich von NLP und Deep Learning Nachholbedarf. Zwar handelt es sich bei ihnen bereits um populäre Buzzwords, doch ein tiefes Verständnis für die Potenziale dieser Technologien und eine dementsprechende Anwendung stehen häufig noch aus. Für Unternehmen gilt es daher, sich erstens Gedanken über die konkreten Vorstellungen zu machen, die sie mit Technologien der künstlichen Intelligenz verbinden und zweitens bei begrenzten internen Kapazitäten, verlässliche Kooperationspartner zu finden, mit denen sie gemeinsam ihre Erwartungen realisieren können. Mehr dazu in Jannas Artikel zu Zielen und Use Cases von NLP.

Zu den Personen

Janna Lipenkova hat einen PhD in Computational Linguistics und verfügt über mehr als 10 Jahre Erfahrung im Bereich des Natural Language Processings sowie seiner Anwendung im Unternehmenskontext. Neben ihren Wirtschaftstätigkeiten unterrichtete Janna an der Universität Stuttgart und der IESEG School of Management, wodurch Sie bereits früh an der Schnittstelle von Wirtschaft und Wissenschaft arbeitete. Aktuell leitet Janna die zwei Big-Data-Unternehmen Anacode und Equintel, mit denen Sie B2B-Kunden bei der Implementierung Ihrer Anwendungspläne von KI und Advanced Analytics unterstützt.

Paul Voges ist seit 2018 hauptverantwortlicher Entwickler bei der Forschungsplattform EDECY und sowohl für die fortlaufende Verbesserung der Plattform als auch für die kontinuierliche Wartung ihrer technischen Infrastruktur zuständig. Währenddessen studiert Paul Medieninformatik an der Hochschule der Medien in Stuttgart. Bei der Implementierung des Natural Language Processings in das Backend der EDECY Plattform arbeitete er eng mit Janna zusammen und stellte eine reibungslose Integration sicher.